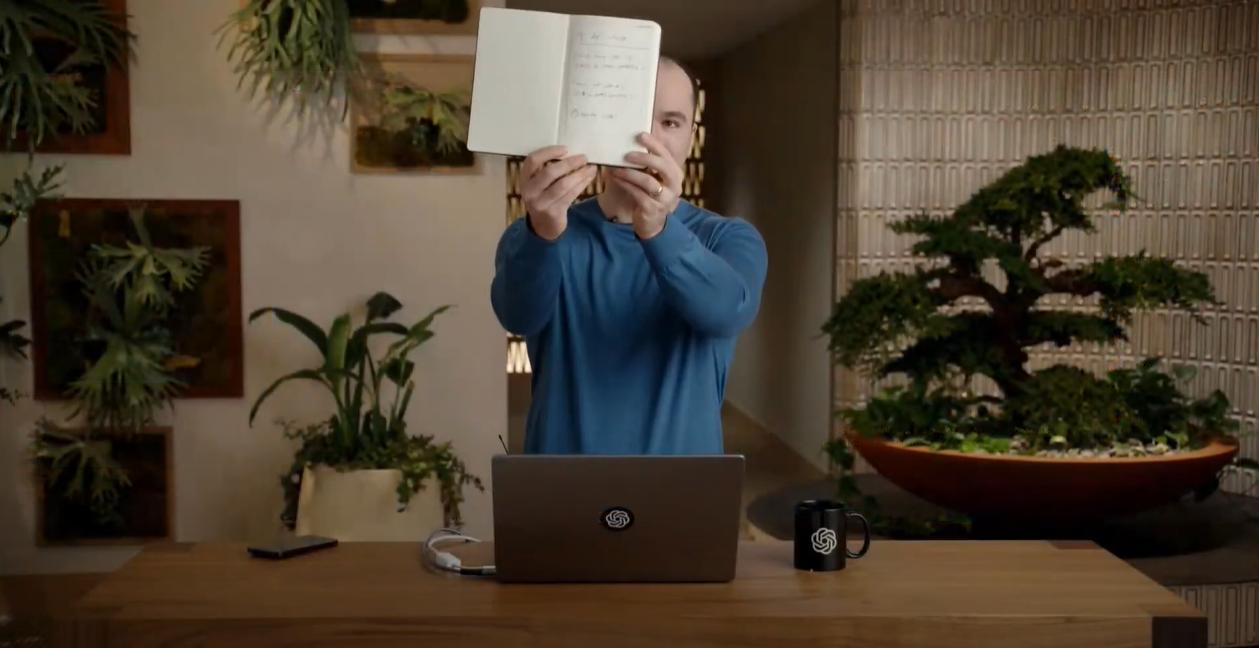

Компания OpenAI представила языковую модель GPT-4. Теперь ИИ умеет распознавать картинки, объяснять мемы и проходить тесты, а задание можно написать от руки и сфотографировать — он разберется. На презентации ведущий сделал в блокноте набросок сайта и загрузил его фото. Нейросеть распознала почерк и сверстала страничку.

По словам главы компании Сэма Альтмана, GPT-4 — «самая способная» ИИ-модель OpenAI и «креативнее» предыдущих версий. При этом разработчик уточнил, что она «по-прежнему с недостатками, ограничена и кажется более впечатляющей при первом использовании, чем после того, как провести с ней больше времени».

Microsoft уже подтвердила, что поисковик Bing работает на адаптированном GPT-4. Кроме того, функцию с распознаванием изображений тестирует сервис для слабовидящих и незрячих Be My Eyes — в приложении появилась функция под названием «виртуальный волонтер».

ИИ отвечает на вопросы об отправленных ему картинках — например, может рассказать о том, что находится в холодильнике, и предложить рецепты из имеющихся продуктов.

Кроме того, новая модель станет доступна платным подписчикам ChatGPT. Сторонние разработчики смогут интегрировать ИИ в свои приложения, но для этого придется записаться в лист ожидания.

В OpenAI отметили, что при обычном разговоре разница между GPT-3.5 и GPT-4 может быть «едва уловимой», но различие заметно, когда задача более сложная и требует «подробных инструкций».

Хочешь быть в курсе главных новостей про инновации и технологии? Подписывайся на нашу рассылку и telegram-канал INNOVATIONS!